pyspark操作hive分区表及.gz.parquet和part-00000文件压缩问题

pyspark 操作hive表

pyspark 操作hive表,hive分区表动态写入;最近发现spark动态写入hive分区,和saveAsTable存表方式相比,文件压缩比大约 4:1。针对该问题整理了 spark 操作hive表的几种方式。

1> saveAsTable写入

saveAsTable(self, name, format=None, mode=None, partitionBy=None, **options)

示例:

df.write.saveAsTable("表名",mode='overwrite')

注意:

1、表不存在则创建表,表存在全覆盖写入;

2、表存在,数据字段有变化,先删除后重新创建表;

3、当正在存表时报错或者终止程序会导致表丢失;

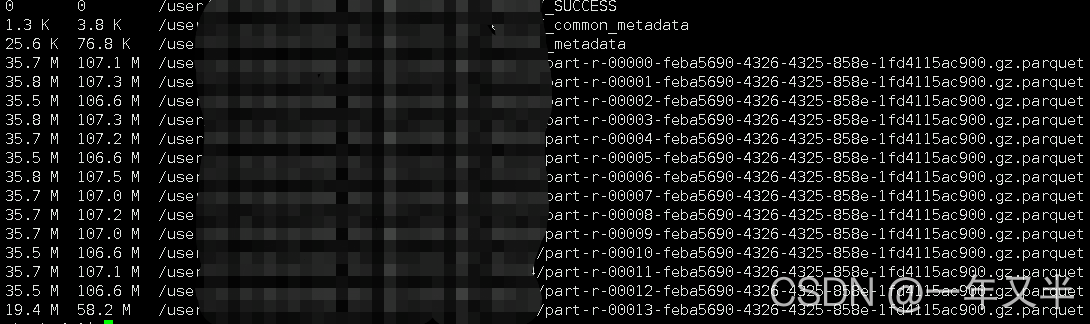

4、数据默认采用parquet压缩,文件名称 part-00000-5efbfc08-66fe-4fd1-bebb-944b34689e70.gz.parquet

数据文件在hdfs上显示:

2> insertInto写入

insertInto(self, tableName, overwrite=False):

示例:

# append 写入

df.repartition(1).write.partitionBy('dt').insertInto("表名")

# overwrite 写入

df.repartition(1).write.partitionBy('dt').insertInto("表名",overwrite=True)

# 动态分区使用该方法

注意:

1、df.write.mode("overwrite").partitionBy("dt").insertInto("表名") 不会覆盖数据

2、需要表必须存在且当前DF的schema与目标表的schema必须一致

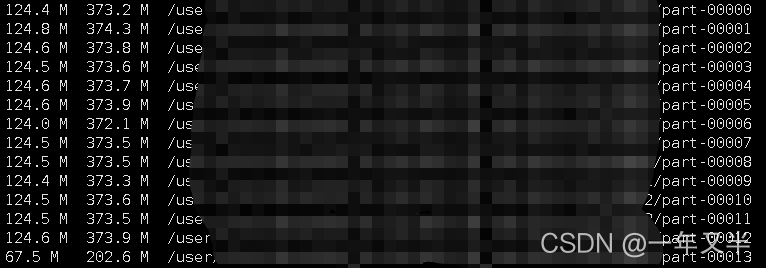

3、插入的文件不会压缩;文件以part-00....结尾。文件较大

数据文件在hdfs上显示:

2.1> 问题说明

两种方式存储数据量一样的数据,磁盘文件占比却相差很大,.gz.parquet 文件 相比 part-00000文件要小很多。想用spark操作分区表,又想让文件压缩,百度了一些方式,都没有解决。

从stackoverflow中有一个类似的问题 Spark compression when writing to external Hive table 。用里面的方法并没有解决。

最终从hive表数据文件压缩角度思考,问题得到解决。

hive 建表指定压缩格式

下面是hive parquet的几种压缩方式

-- 使用snappy

CREATE TABLE if not exists ods.table_test(

id string,

open_time string

)

COMMENT '测试'

PARTITIONED BY (`dt` string COMMENT '按天分区')

row format delimited fields terminated by '\001'

STORED AS PARQUET

TBLPROPERTIES ('parquet.compression'='SNAPPY');

-- 使用gzip

CREATE TABLE if not exists ods.table_test(

id string,

open_time string

)

COMMENT '测试'

PARTITIONED BY (`dt` string COMMENT '按天分区')

row format delimited fields terminated by '\001'

STORED AS PARQUET

TBLPROPERTIES ('parquet.compression'='GZIP');

-- 使用uncompressed

CREATE TABLE if not exists ods.table_test(

id string,

open_time string

)

COMMENT '测试'

PARTITIONED BY (`dt` string COMMENT '按天分区')

row format delimited fields terminated by '\001'

STORED AS PARQUET

TBLPROPERTIES ('parquet.compression'='UNCOMPRESSED');

-- 使用默认

CREATE TABLE if not exists ods.table_test(

id string,

open_time string

)

COMMENT '测试'

PARTITIONED BY (`dt` string COMMENT '按天分区')

row format delimited fields terminated by '\001'

STORED AS PARQUET;

-- 设置参数 set parquet.compression=SNAPPY;

2.2> 解决办法

建表时指定TBLPROPERTIES,采用gzip 压缩

示例:

drop table if exists ods.table_test

CREATE TABLE if not exists ods.table_test(

id string,

open_time string

)

COMMENT '测试'

PARTITIONED BY (`dt` string COMMENT '按天分区')

row format delimited fields terminated by '\001'

STORED AS PARQUET

TBLPROPERTIES ('parquet.compression'='GZIP');

执行效果

数据文件在hdfs上显示:

可以看到文件大小占比已经和 *.gz.parquet 文件格式一样了

3>saveAsTextFile写入直接操作文件saveAsTextFile(self, path, compressionCodecClass=None)

该方式通过rdd 以文件形式直接将数据存储在hdfs上。

示例:

rdd.saveAsTextFile('hdfs://表全路径')

文件操作更多方式见官方文档

到此这篇关于pyspark操作hive分区表及.gz.parquet和part-00000文件压缩问题的文章就介绍到这了,更多相关pyspark hive分区表parquet内容请搜索猪先飞以前的文章或继续浏览下面的相关文章希望大家以后多多支持猪先飞!

相关文章

- 通过合理的设计,可以将选择一定的规则,将大表切分多个不重不漏的子表,这就是传说中的partitioning。比如,我们可以按时间切分,每天一张子表,比如我们可以按照某其他字段分割,总之了就是化整为零,提高查询的效能...2020-07-11

- 这篇文章主要给大家介绍了关于MySQL分区表的基本入门教程,文中通过示例代码介绍的非常详细,对大家学习或者使用MySQL具有一定的参考学习价值,需要的朋友们下面来一起学习学习吧...2020-06-01

- PHP ZipArchive 是PHP自带的扩展类,可以轻松实现ZIP文件的压缩和解压,使用前首先要确保PHP ZIP 扩展已经开启,具体开启方法这里就不说了,不同的平台开启PHP扩增的方法网上都有,如有疑问欢迎交流。这里整理一下利用php zipA...2015-10-30

pyspark操作hive分区表及.gz.parquet和part-00000文件压缩问题

这篇文章主要介绍了pyspark操作hive分区表及.gz.parquet和part-00000文件压缩问题,针对问题整理了spark操作hive表的几种方式,需要的朋友可以参考下...2021-08-25- 这篇文章主要介绍了hive中将string数据转为bigint的操作,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧...2020-12-08

- 这篇文章主要介绍了解决hive中导入text文件遇到的坑,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧...2021-04-07

php中Fatal error: Class ZipArchive not found的解决办法

php在使用ZipArchive类时出现Fatal error: Class ZipArchive not found错误提示,下面我们来介绍在linux 与windows中的解决办法。 出现这个错误说明是程序在调用'Z...2016-11-25解决PHP报错ZipArchive library is not enabled异常的方法

本文章为各位介绍一篇关于解决PHP报错ZipArchive library is not enabled异常的方法,希望文章能够对大家有帮助。 今天在Linux底下上传Excel文件时,抛出“ZipArc...2016-11-25- 文章简单的介绍了关于PHP中ZipArchive压缩文件并下载打包好的文件介绍 ,有需要了解php中文件打包的朋友可参考五下。 分析下技术要点: 将文件打包成zip格式 下载...2016-11-25

- 这篇文章主要给大家介绍了关于MySQL最佳实践之分区表基本类型的相关资料,文中通过示例代码介绍的非常详细,对大家学习或者使用MySQL具有一定的参考学习价值,需要的朋友们下面来一起学习学习吧...2020-06-01

- 为了便于操作,使用pyspark时我们通常将数据转为DataFrame的形式来完成清洗和分析动作。那么你知道pyspark创建DataFrame有几种方法吗,下面就一起来了解一下...2021-05-17

- 这篇文章主要介绍了MySQL分区表的相关资料,帮助大家更好的理解和学习mysql,感兴趣的朋友可以了解下...2020-08-11

php使用ZipArchive提示Fatal error: Class ZipArchive not found in

ZipArchive是php自带的一个压缩与解压缩函数了,今天理所当然的情况中使用new ZipArchive来创建zip文件时碰到提示Fatal error: Class ZipArchive not found in错误,下面...2016-11-25- 这篇文章主要介绍了分区表场景下的 SQL 优化,帮助大家更好的理解和学习SQL,感兴趣的朋友可以了解下...2020-12-08

- pyspark是Spark对Python的api接口,可以在Python环境中通过调用pyspark模块来操作spark,这篇文章主要介绍了windowns使用PySpark环境配置和基本操作,感兴趣的可以了解一下...2021-05-17

- ZipArchive类是一个文件压缩解压类是一个php自来的zip类,我们可以直接简单创建一个类然后就能实现打包了,下面一聚教程小编给各位介绍一下吧,有需要了解的朋友可进入参考...2016-11-25

- php ZipArchive可以说是php自带的一个函数了,他可对对文件进行压缩与解压缩处理,但是使用此类之前我们必须在php.ini中把extension=php_zip.dll前面的分号有没有去掉,然...2016-11-25

- 如果你使用的是php5.2以下的php版本是无法使用ZipArchive类的,只要php5.2及以上版本才可以方便的使用ZipArchive类来解压与压缩zip文件了,下面小编来给各位同学介绍一下...2016-11-25

用 Python 定义 Schema 并生成 Parquet 文件详情

本文将演示两个例子,一个是没有层级的两个字段,另一个是含于嵌套级别的字段,将要使用到的 Python 模块有 pandas 和 pyarrow,感兴趣是我小伙伴请和小编一起学习下面文章内容吧...2021-09-25- 这篇文章主要介绍了pyspark对Mysql数据库进行读写的实现,文中通过示例代码介绍的非常详细,对大家的学习或者工作具有一定的参考学习价值,需要的朋友们下面随着小编来一起学习学习吧...2020-12-30