pytorch-RNN进行回归曲线预测方式

更新时间:2020年4月27日 21:20 点击:1705

任务

通过输入的sin曲线与预测出对应的cos曲线

#初始加载包 和定义参数 import torch from torch import nn import numpy as np import matplotlib.pyplot as plt torch.manual_seed(1) #为了可复现 #超参数设定 TIME_SETP=10 INPUT_SIZE=1 LR=0.02 DOWNLoad_MNIST=True

定义RNN网络结构

from torch.autograd import Variable

class RNN(nn.Module):

def __init__(self):

#在这个函数中,两步走,先init,再逐步定义层结构

super(RNN,self).__init__()

self.rnn=nn.RNN( #定义32隐层的rnn结构

input_size=1,

hidden_size=32, #隐层有32个记忆体

num_layers=1, #隐层层数是1

batch_first=True

)

self.out=nn.Linear(32,1) #32个记忆体对应一个输出

def forward(self,x,h_state):

#前向过程,获取 rnn网络输出r_put(注意这里r_out并不是最后输出,最后要经过全连接层) 和 记忆体情况h_state

r_out,h_state=self.rnn(x,h_state)

outs=[]#获取所有时间点下得到的预测值

for time_step in range(r_out.size(1)): #将记忆rnn层的输出传到全连接层来得到最终输出。 这样每个输入对应一个输出,所以会有长度为10的输出

outs.append(self.out(r_out[:,time_step,:]))

return torch.stack(outs,dim=1),h_state #将10个数 通过stack方式压缩在一起

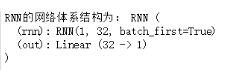

rnn=RNN()

print('RNN的网络体系结构为:',rnn)

创建数据集及网络训练

以sin曲线为特征,以cos曲线为标签进行网络的训练

#定义优化器和 损失函数

optimizer=torch.optim.Adam(rnn.parameters(),lr=LR)

loss_fun=nn.MSELoss()

h_state=None #记录的隐藏层状态,记住这就是记忆体,初始时候为空,之后每次后面的都会使用到前面的记忆,自动生成全0的

#这样加入记忆信息后,每次都会在之前的记忆矩阵基础上再进行新的训练,初始是全0的形式。

#启动训练,这里假定训练的批次为100次

plt.ion() #可以设定持续不断的绘图,但是在这里看还是间断的,这是jupyter的问题

for step in range(100):

#我们以一个π为一个时间步 定义数据,

start,end=step*np.pi,(step+1)*np.pi

steps=np.linspace(start,end,10,dtype=np.float32) #注意这里的10并不是间隔为10,而是将数按范围分成10等分了

x_np=np.sin(steps)

y_np=np.cos(steps)

#将numpy类型转成torch类型 *****当需要 求梯度时,一个 op 的两个输入都必须是要 Variable,输入的一定要variable包下

x=Variable(torch.from_numpy(x_np[np.newaxis,:,np.newaxis]))#增加两个维度,是三维的数据。

y=Variable(torch.from_numpy(y_np[np.newaxis,:,np.newaxis]))

#将每个时间步上的10个值 输入到rnn获得结果 这里rnn会自动执行forward前向过程. 这里输入时10个,输出也是10个,传递的是一个长度为32的记忆体

predition,h_state=rnn(x,h_state)

#更新新的中间状态

h_state=Variable(h_state.data) #擦,这点一定要从新包装

loss=loss_fun(predition,y)

#print('loss:',loss)

optimizer.zero_grad()

loss.backward()

optimizer.step()

# plotting 画图,这里先平展了 flatten,这样就是得到一个数组,更加直接

plt.plot(steps, y_np.flatten(), 'r-')

plt.plot(steps, predition.data.numpy().flatten(), 'b-')

#plt.draw();

plt.pause(0.05)

plt.ioff() #关闭交互模式

plt.show()

以上这篇pytorch-RNN进行回归曲线预测方式就是小编分享给大家的全部内容了,希望能给大家一个参考,也希望大家多多支持猪先飞。

上一篇: python重要函数eval多种用法解析

下一篇: 基于pytorch的lstm参数使用详解

相关文章

pytorch nn.Conv2d()中的padding以及输出大小方式

今天小编就为大家分享一篇pytorch nn.Conv2d()中的padding以及输出大小方式,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧...2020-04-27- 这篇文章主要介绍了PyTorch一小时掌握之迁移学习篇,本文给大家介绍的非常详细,对大家的学习或工作具有一定的参考借鉴价值,需要的朋友可以参考下...2021-09-08

Linux安装Pytorch1.8GPU(CUDA11.1)的实现

这篇文章主要介绍了Linux安装Pytorch1.8GPU(CUDA11.1)的实现,文中通过示例代码介绍的非常详细,对大家的学习或者工作具有一定的参考学习价值,需要的朋友们下面随着小编来一起学习学习吧...2021-03-25- 这篇文章主要介绍了Pytorch之扩充tensor的操作,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧...2021-03-05

- 今天小编就为大家分享一篇pytorch 自定义卷积核进行卷积操作方式,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧...2020-05-06

- 这篇文章主要介绍了解决pytorch 交叉熵损失输出为负数的问题,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧...2020-07-08

pytorch绘制并显示loss曲线和acc曲线,LeNet5识别图像准确率

今天小编就为大家分享一篇pytorch绘制并显示loss曲线和acc曲线,LeNet5识别图像准确率,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧...2020-05-02- 这篇文章主要介绍了pytorch 实现冻结部分参数训练另一部分,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧...2021-03-27

从Pytorch模型pth文件中读取参数成numpy矩阵的操作

这篇文章主要介绍了从Pytorch模型pth文件中读取参数成numpy矩阵的操作,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧...2021-03-04Pytorch 的损失函数Loss function使用详解

今天小编就为大家分享一篇Pytorch 的损失函数Loss function使用详解,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧...2020-05-02- 今天小编就为大家分享一篇pytorch中的上采样以及各种反操作,求逆操作详解,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧...2020-04-30

- 这篇文章主要介绍了基于Pytorch版yolov5的滑块验证码破解思路详解,本文给大家介绍的非常详细,对大家的学习或工作具有一定的参考借鉴价值,需要的朋友可以参考下...2021-02-25

pytorch中交叉熵损失(nn.CrossEntropyLoss())的计算过程详解

今天小编就为大家分享一篇pytorch中交叉熵损失(nn.CrossEntropyLoss())的计算过程详解,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧...2020-05-02- 这篇文章主要介绍了pytorch深度学习中对softmax实现进行了详细解析,有需要的朋友可以借鉴参考下,希望能够有所帮助,祝大家多多进步...2021-09-30

- 今天小编就为大家分享一篇Pytorch 计算误判率,计算准确率,计算召回率的例子,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧...2020-04-27

- 这篇文章主要介绍了pytorch中的squeeze函数、cat函数使用,具有很好的参考价值,希望对大家有所帮助。如有错误或未考虑完全的地方,望不吝赐教...2021-05-20

- 今天小编就为大家分享一篇Pytorch实现LSTM和GRU示例,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧...2020-04-27

- 这篇文章主要介绍了Pytorch如何切换 cpu和gpu的使用详解,文中通过示例代码介绍的非常详细,对大家的学习或者工作具有一定的参考学习价值,需要的朋友们下面随着小编来一起学习学习吧...2021-03-01

解决Pytorch dataloader时报错每个tensor维度不一样的问题

这篇文章主要介绍了解决Pytorch dataloader时报错每个tensor维度不一样的问题,具有很好的参考价值,希望对大家有所帮助。如有错误或未考虑完全的地方,望不吝赐教...2021-05-28- 今天小编就为大家分享一篇pytorch动态网络以及权重共享实例,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧...2020-04-29