Python爬取求职网requests库和BeautifulSoup库使用详解

一、requests库

1、requests简介

requests库就是一个发起请求的第三方库,requests允许你发送HTTP/1.1 请求,你不需要手动为 URL 添加查询字串,也不需要对 POST 数据进行表单编码。Keep-alive 和 HTTP 连接池的功能是 100% 自动化的,一切动力都来自于根植在 requests 内部的 urllib3。简单来说有了这个库,我们就能轻而易举向对应的网站发起请求,从而对网页数据进行获取,还可以获取服务器返回的响应内容和状态码。

requesets中文文档页面https://requests.kennethreitz.org/zh_CN/latest/

2、安装requests库

一般电脑安装的Python都会自带这个库,如果没有就可在命令行输入下面这行代码安装

pip install requests

3、使用requests获取网页数据 我们先导入模块

import requests

- 对想要获取数据的网站发起请求,以下以qq音乐官网为例

res = requests.get('https://y.qq.com/') #发起请求

print(res) #输出<Response [200]>

输出的200其实就是一个响应状态码,下面给大家列出有可能返回的各状态码含义

| 状态码 | 含义 |

|---|---|

| 1xx | 继续发送信息 |

| 2xx | 请求成功 |

| 3xx | 重定向 |

| 4xx | 客户端错误 |

| 5xx | 服务端错误 |

- 获取qq音乐首页的网页源代码

res = requests.get('https://y.qq.com/') #发起请求

print(res.text) #res.text就是网页的源代码

4、总结requests的一些方法

| 属性 | 含义 |

|---|---|

| res.status_code | HTTP的状态码 |

| res.text | 响应内容的文本 |

| res.content | 响应内容的二进制形式文本 |

| res.encoding | 响应内容的编码 |

既然我们学好了如何获取网页源代码,接下来我们就学习下怎么用BeautifulSoup库对我们获取的内容进行提取。

二、BeautifulSoup库

1、BeautifulSoup简介

BeautifulSoup是Python里的第三方库,处理数据十分实用,有了这个库,我们就可以根据网页源代码里对应的HTML标签对数据进行有目的性的提取。BeautifulSoup库一般与requests库搭配使用。 不熟的HTML标签的最好去百度下,了解一些常用的标签。

2、安装BeautifulSoup库

同样的如果没用这个库,可以通过命令行输入下列代码安装

pip install beautifulsoup4

3、使用BeautifulSoup解析并提取获取的数据

import requests

from bs4 import BeautifulSoup

header={'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/87.0.4280.66 Safari/537.36'}

res = requests.get('https://y.qq.com/',headers=header) #headers是一种反爬虫措施

soup = BeautifulSoup(res.text,'html.parser') #第一个参数是HTML文本,第二个参数html.parser是Python内置的编译器

print(soup) #输出qq音乐首页的源代码

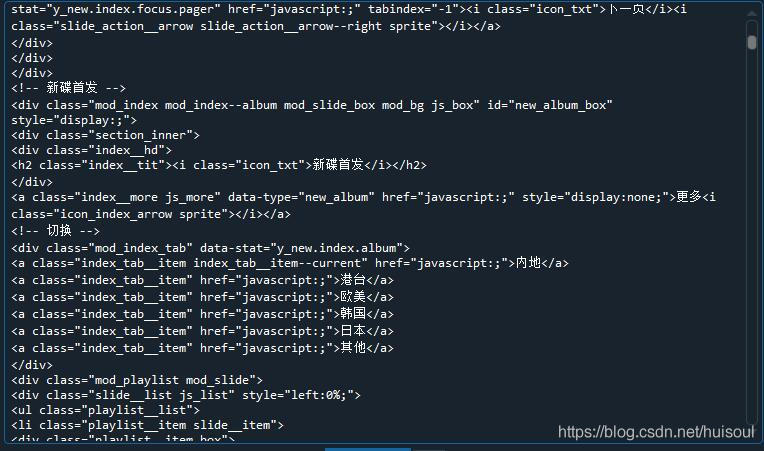

部分输出结果

看到输出结果,我们已经成功将网页源代码解析成BeautifulSoup对象。这时可能有人就会问res.text输出的不就是网页代码了吗,何苦再将它转为BeautifulSoup对象呢?

我们先来通过type()函数看下它们的类型

import requests

from bs4 import BeautifulSoup

header={'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/87.0.4280.66 Safari/537.36'}

res = requests.get('https://y.qq.com/',headers=header) #headers是一种反爬虫措施

soup = BeautifulSoup(res.text,'html.parser') #第一个参数是HTML文本,第二个参数html.parser是Python内置的编译器

print(type(res.text))

print(type(soup))

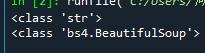

输出结果

我们可以看到res.text的类型是字符串类型,而soup则是BeautifulSoup对象类型。相比于res.text的字符串类型,soup的BeautifulSoup对象类型拥有着更多可用的方法,以便我们快速提取出需要的数据。这就是为什么我们要多此一步了。

4、BeautifulSoup提取数据的方法

- 先来了解两个最常用的方法

| 方法 | 作用 |

|---|---|

| find() | 返回第一个符合要求的数据 |

| find_all() | 返回所有符合要求的数据 |

这两个函数传入的参数就是我们对数据的筛选条件了,我们可以向这两个函数分别传入什么参数呢?

我们以下面在qq音乐首页截取的源代码片段为例,试用两个函数

<div class="index__hd">

<h2 class="index__tit"><i class="icon_txt">歌单推荐</i></h2>

</div>

<!-- 切换 -->

<div class="mod_index_tab" data-stat="y_new.index.playlist">

<a href="javascript:;" rel="external nofollow" rel="external nofollow" rel="external nofollow" rel="external nofollow" rel="external nofollow" rel="external nofollow" class="index_tab__item index_tab__item--current js_tag" data-index="0" data-type="recomPlaylist" data-id="1">为你推荐</a>

<a href="javascript:;" rel="external nofollow" rel="external nofollow" rel="external nofollow" rel="external nofollow" rel="external nofollow" rel="external nofollow" class="index_tab__item js_tag" data-type="playlist" data-id="3056">网络歌曲</a>

<a href="javascript:;" rel="external nofollow" rel="external nofollow" rel="external nofollow" rel="external nofollow" rel="external nofollow" rel="external nofollow" class="index_tab__item js_tag" data-type="playlist" data-id="3256">综艺</a>

<a href="javascript:;" rel="external nofollow" rel="external nofollow" rel="external nofollow" rel="external nofollow" rel="external nofollow" rel="external nofollow" class="index_tab__item js_tag" data-type="playlist" data-id="59">经典</a>

<a href="javascript:;" rel="external nofollow" rel="external nofollow" rel="external nofollow" rel="external nofollow" rel="external nofollow" rel="external nofollow" class="index_tab__item js_tag" data-type="playlist" data-id="3317">官方歌单</a>

<a href="javascript:;" rel="external nofollow" rel="external nofollow" rel="external nofollow" rel="external nofollow" rel="external nofollow" rel="external nofollow" class="index_tab__item js_tag" data-type="playlist" data-id="71">情歌</a>

</div>

find()函数

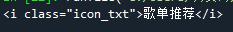

如果想要获取歌单推荐这一行的内容,我们就需要先对歌单推荐的HTML标签进行识别,我们发现它在class="icon_txt"的i标签下,接着就可以通过以下这种方法进行提取

import requests

from bs4 import BeautifulSoup

header={'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/87.0.4280.66 Safari/537.36'}

res = requests.get('https://y.qq.com/',headers=header) #headers是一种反爬虫措施

soup = BeautifulSoup(res.text,'html.parser') #第一个参数是HTML文本,第二个参数html.parser是Python内置的编译器

print(soup.find('i', class_='icon_txt')) #找到 class_='icon_txt'的 i 标签

因为 class 是 Python 中定义类的关键字,所以用 class_ 表示 HTML 中的 class

输出结果

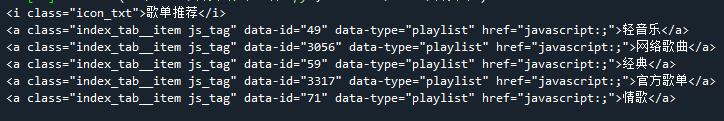

find_all()函数

如果我们想要把歌单推荐的全部主题提取下来的话,就要用到find_all()函数

同样的,我们发现这几个主题都在 class="index_tab__item js_tag"的 a标签下,这时为了避免筛选到源代码中其他同为class="index_tab__item js_tag"的标签,我们需要再加多一个条件data-type=“playlist”,具体怎么操作呢?

import requests

from bs4 import BeautifulSoup

header={'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/87.0.4280.66 Safari/537.36'}

res = requests.get('https://y.qq.com/',headers=header) #headers是一种反爬虫措施

soup = BeautifulSoup(res.text,'html.parser') #第一个参数是HTML文本,第二个参数html.parser是Python内置的编译器

print(soup.find('i', class_='icon_txt'))

items = soup.find_all('a',attrs={"class" :"index_tab__item js_tag","data-type":"playlist"})

实现的方法就是在第二个参数处传入一个键值对,在里面添加筛选的属性

输出结果

通过上面两个小案例,我们发现find()和find_all()函数返回的是Tag对象和Tag对象组成的列表,而我们需要的并不是这一大串东西,我们需要的只是Tag对象的text属性或者href(链接)属性,实现代码如下

import requests

from bs4 import BeautifulSoup

header={'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/87.0.4280.66 Safari/537.36'}

res = requests.get('https://y.qq.com/',headers=header) #headers是一种反爬虫措施

soup = BeautifulSoup(res.text,'html.parser') #第一个参数是HTML文本,第二个参数html.parser是Python内置的编译器

tag1=soup.find('i', class_='icon_txt')

print(tag1.text)

items = soup.find_all('a',attrs={"class" :"index_tab__item js_tag","data-type":"playlist"})

for i in items: #遍历列表

tag2=i.text

print(tag2)

输出结果

这样我们就成功把主题的文本内容获取了,而想要提取标签中的属性值,则可以用对象名[‘属性']的方法获取,这里就不演示了

本次分享就到这里了,在下次介绍完反爬虫和如何将数据写进文件的方法后,我会结合我所写的三篇文章的方法来做一个爬取求职网的实例跟大家分享,有兴趣的可以看下,谢谢大家!

希望大家以后多多支持猪先飞!

原文出处:https://blog.csdn.net/huisoul/article/details/116051442

相关文章

- 操作类就是把一些常用的一系列的数据库或相关操作写在一个类中,这样调用时我们只要调用类文件,如果要执行相关操作就直接调用类文件中的方法函数就可以实现了,下面整理了...2016-11-25

- 本文给大家分享C#连接SQL数据库和查询数据功能的操作技巧,本文通过图文并茂的形式给大家介绍的非常详细,需要的朋友参考下吧...2021-05-17

- 这篇文章主要介绍了C#从数据库读取图片并保存的方法,帮助大家更好的理解和使用c#,感兴趣的朋友可以了解下...2021-01-16

- 这篇文章主要介绍了Intellij IDEA连接Navicat数据库的方法,本文通过图文并茂的形式给大家介绍的非常详细,对大家的学习或工作具有一定的参考借价值,需要的朋友可以参考下...2021-03-25

- 在开发过程中,我们经常会将日期时间的毫秒数存放到数据库,但是它对应的时间看起来就十分不方便,我们可以使用一些函数将毫秒转换成date格式。 一、 在MySQL中,有内置的函数from_unixtime()来做相应的转换,使用如下: 复制...2014-05-31

- C#使用System.IO中的文件操作方法在Windows系统中处理本地文件相当顺手,这里我们还总结了在Oracle中保存文件的方法,嗯,接下来就来看看整理的C#操作本地文件及保存文件到数据库的基本方法总结...2020-06-25

- 通过内网连另外一台机器的mysql服务, 确发现速度N慢! 等了大约几十秒才等到提示输入密码。 但是ping mysql所在服务器却很快! 想到很久之前有过类似的经验, telnet等一些服务在连接请求的时候,会做一些反向域名解析(如果...2015-10-21

- 某些时候,例如为了搭建一个测试环境,或者克隆一个网站,需要复制一个已存在的mysql数据库。使用以下方法,可以非常简单地实现。假设已经存在的数据库名字叫db1,想要复制一份,命名为newdb。步骤如下:1. 首先创建新的数据库newd...2015-10-21

- mysqldump命令的用法1、导出所有库系统命令行mysqldump -uusername -ppassword --all-databases > all.sql 2、导入所有库mysql命令行mysql>source all.sql; 3、导出某些库系统命令行mysqldump -uusername -ppassword...2015-10-21

- 1005:创建表失败1006:创建数据库失败1007:数据库已存在,创建数据库失败1008:数据库不存在,删除数据库失败1009:不能删除数据库文件导致删除数据库失败1010:不能删除数据目录导致删除数据库失败1011:删除数据库...2013-09-23

- 这篇文章主要介绍了C++万能库头文件在vs中的安装步骤(图文),文中通过示例代码介绍的非常详细,对大家的学习或者工作具有一定的参考学习价值,需要的朋友们下面随着小编来一起学习学习吧...2021-02-23

- 这篇文章主要介绍了c#从数据库里取得数据并异步更新ui的方法,大家参考使用吧...2020-06-25

- yii2.0框架是PHP开发的一个比较高效率的框架,集合了作者的大量心血,下面通过用户为例给大家详解yii2使用中的一些基本的增删改查操作。 User::find()->all(); //返回所有用户数据; User::findOne($id); //返回 主键...2015-11-24

- 1.用phpmyadmin创建数据库和数据表 创建数据库的时候,请将“整理”设置为:“utf8_general_ci” 或执行语句: 复制代码 代码如下:CREATE DATABASE `dbname` DEFAULT CHARACTER SET utf8 COLLATE utf8_general_ci; 创...2015-10-21

- 这篇文章主要介绍了springBoot 项目排除数据库启动方式,具有很好的参考价值,希望对大家有所帮助。如有错误或未考虑完全的地方,望不吝赐教...2021-09-10

- 本文给大家分享基于js实现仿百度文库评分功能,代码简单易懂,非常不错,具有参考借鉴价值,需要的的朋友参考下吧...2017-01-16

- 距离 Vue 3.0 正式版发布已经有一段时间了,关于vue3组件库相关的问题还是挺多人感兴趣的,这篇文章主要给大家介绍了关于vue3如何按需加载第三方组件库的相关资料,需要的朋友可以参考下...2021-06-02

- 这篇文章主要介绍了Linux 下使用shell脚本定时维护数据库,本文通过案例分析给大家介绍的非常详细,对大家的学习或工作具有一定的参考借鉴价值,需要的朋友可以参考下...2020-07-11

- 今天带大家来学习selenium库的使用方法及相关知识总结,文中非常详细的介绍了selenium库,对正在学习python的小伙伴很有帮助,需要的朋友可以参考下...2021-05-25

- “主机,用户名,密码”得到连接、“数据库,sql,连接”得到结果,最后是结果的处理显示。当然,数据库连接是扩展库为我们完成的,我们能做的仅仅是处理结果而已。...2013-09-29