如何使用flask将模型部署为服务

更新时间:2021年5月14日 00:00 点击:2299

1. 加载保存好的模型

为了方便起见,这里我们就使用简单的分词模型,相关代码如下:model.py

import jieba

class JiebaModel:

def load_model(self):

self.jieba_model = jieba.lcut

def generate_result(self, text):

return self.jieba_model(text, cut_all=False)

说明:在load_model方法中加载保存好的模型,无论是sklearn、tensorflow还是pytorch的都可以在里面完成。在generate_result方法中定义处理输入后得到输出的逻辑,并返回结果。

2. 使用flask起服务

代码如下:test_flask.py

# -*-coding:utf-8-*-

from flask import Flask, request, Response, abort

from flask_cors import CORS

# from ast import literal_eval

import time

import sys

import json

import traceback

from model import JiebaModel

app = Flask(__name__)

CORS(app) # 允许所有路由上所有域使用CORS

@app.route("/", methods=['POST', 'GET'])

def inedx():

return '分词程序正在运行中'

@app.route("/split_words", methods=['POST', 'GET'])

def get_result():

if request.method == 'POST':

text = request.data.decode("utf-8")

else:

text = request.args['text']

try:

start = time.time()

print("用户输入",text)

res = jiebaModel.generate_result(text)

end = time.time()

print('分词耗时:', end-start)

print('分词结果:', res)

result = {'code':'200','msg':'响应成功','data':res}

except Exception as e:

print(e)

result_error = {'errcode': -1}

result = json.dumps(result_error, indent=4, ensure_ascii=False)

# 这里用于捕获更详细的异常信息

exc_type, exc_value, exc_traceback = sys.exc_info()

lines = traceback.format_exception(exc_type, exc_value, exc_traceback)

# 提前退出请求

abort(Response("Failed!\n" + '\n\r\n'.join('' + line for line in lines)))

return Response(str(result), mimetype='application/json')

if __name__ == "__main__":

jiebaModel = JiebaModel()

jiebaModel.load_model()

app.run(host='0.0.0.0', port=1314, threaded=False)

说明:我们定义了一个get_result()函数,对应的请求是ip:port/split_words。 首先我们根据请求是get请求还是post请求获取数据,然后使用模型根据输入数据得到输出结果,并返回响应给请求。如果遇到异常,则进行相应的处理后并返回。在__main__中,我们引入了model.py的JiebaModel类,然后加载了模型,并在get_result()中调用。

3. 发送请求并得到结果

代码如下:test_request.py

import requests

def get_split_word_result(text):

res = requests.post('http://{}:{}/split_words'.format('本机ip', 1314), data=str(text).encode('utf-8'))

print(res.text)

get_split_word_result("我爱北京天安门")

说明:通过requests发送post请求,请求数据编码成utf-8的格式,最后得到响应,并利用.text得到结果。

4. 效果呈现

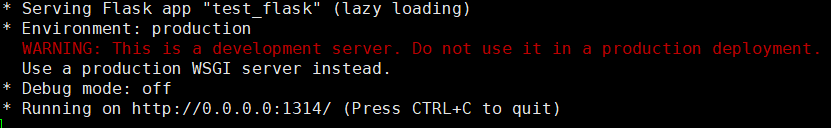

(1)运行test_flask.py

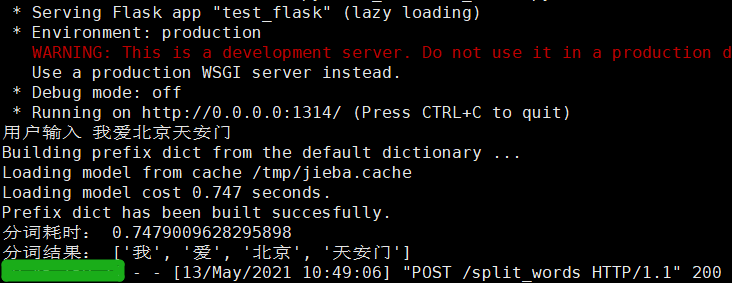

(2)运行test_request.py

并在起服务的位置看到:

以上就是如何使用flask将模型部署为服务的详细内容,更多关于用flask将模型部署为服务的资料请关注猪先飞其它相关文章!

相关文章

- 今天小编就为大家分享一篇python 实现Flask中返回图片流给前端展示,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧...2020-04-27

- 如今高要求的分布式系统的建造者遇到了不能完全由传统的面向对象编程(OOP)模型解决的挑战,但这可以从Actor模型中获益。...2021-05-20

解决在keras中使用model.save()函数保存模型失败的问题

这篇文章主要介绍了解决在keras中使用model.save()函数保存模型失败的问题,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧...2020-05-21- 这篇文章主要介绍了Python通过VGG16模型实现图像风格转换操作,结合实例形式详细分析了Python使用VGG16模型实现图像风格转换的具体原理、操作步骤与实现方法,需要的朋友可以参考下...2020-04-27

- 这篇文章主要介绍了解决Keras 中加入lambda层无法正常载入模型问题,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧...2020-06-17

- 今天小编就为大家分享一篇PyTorch使用cpu加载模型运算方式,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧...2020-04-27

- 这篇文章主要介绍了keras的三种模型实现与区别说明,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧...2020-07-04

- 今天小编就为大家分享一篇Tensorflow读取并输出已保存模型的权重数值方式,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看不看...2020-04-30

- 今天小编就为大家分享一篇pytorch获取模型某一层参数名及参数值方式,具有很好的价值,希望对大家有所帮助。一起跟随小编过来看看吧...2020-05-08

Python如何使用logging为Flask增加logid

这篇文章主要介绍了Python如何使用logging为Flask增加logid,帮助大家更好的理解和学习使用python,感兴趣的朋友可以了解下...2021-03-30- 这篇文章主要介绍了PyTorch 多GPU下模型的保存与加载(踩坑笔记),文中通过示例代码介绍的非常详细,对大家的学习或者工作具有一定的参考学习价值,需要的朋友们下面随着小编来一起学习学习吧...2021-03-09

- 今天带大家复习python框架的相关知识,文中对flask作了非常详细的介绍,对正在学习python的小伙伴们有很好的帮助,需要的朋友可以参考下...2021-05-25

- 这篇文章主要介绍了pytorch模型的保存和加载、checkpoint操作,具有很好的参考价值,希望对大家有所帮助。如有错误或未考虑完全的地方,望不吝赐教...2021-06-06

- 在本篇内容里小编给大家整理的是一篇关于flask开启多线程的具体方法,对此有需求的可以学习参考下。...2020-08-03

- 在某些场景下,我们需要将机器学习或者深度学习模型部署为服务给其它地方调用,本文接下来就讲解使用python的flask部署服务的基本过程。...2021-05-14

- 在flask中,想要给前端页面返回数据,必须是Response的对象,本文介绍了Flask response响应的使用,感兴趣的可以了解一下...2021-07-15

- 这篇文章主要介绍了CI(CodeIgniter)模型用法,结合实例形式分析了CodeIgniter框架中模型的功能、使用方法与相关注意事项,需要的朋友可以参考下...2016-01-23

- 今天小编就为大家分享一篇tensorflow如何继续训练之前保存的模型实例,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧...2020-04-22

- 多对多就相当于一个专题Topic有多个文章,但是这多个文章又属于多个专题,下面这篇文章主要给大家介绍了关于laravel多对多关联模型的相关资料,需要的朋友可以参考下...2021-08-11

- 这篇文章主要介绍了keras实现调用自己训练的模型,并去掉全连接层,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧...2020-06-10